Robots culpables

Las guerras incrementan el uso de máquinas. Desde 2004, el número de sistemas no tripulados desplegados en Irak, por ejemplo, paso de menos de 200 a más de 18.000. Si tenemos en cuenta que para los soldados humanos es difícil tomar decisiones racionales, éticas y legales que sean fiables en medio del calor del combate, el aumento de robots en un conflicto podría ser un motivo para dejar de preocuparnos.

Imagina robots que obedezcan a mandatos que sigan el imperativo categórico de Immanuel Kant -actuar racionalmente y con un sentido de deber moral-. El experto en robótica, Ronald Arkin, terminó un proyecto encargado por Ejército estadounidense que consiste en el diseño de un software para que los robots sean capaces de tomar decisiones éticas y autónomas. Arkin afirma que en situaciones límites, como las operaciones 'counter sniper' o asaltos a edificios, el software puede permitir a los robots superar a los humanos desde una perspectiva ética.

"Estos sistemas tendrían más información disponible que la podría procesar un soldado humano, por lo que, probablemente puedan tomar mejores decisiones”, dice.

El software de Arkin, "Arquitectura ética", se basa en las leyes internacionales de la guerra y en las reglas de enfrentamiento. El comportamiento de los robots "está literalmente regido por estas leyes. En una situación hipotética, un robot apuntaría a los soldados enemigos, pero no necesariamente abriría fuego”.

Pero ser un robot ético implica algo más que reglas. Estas máquinas también tendrían algo similar a las emociones, en particular, la culpa. Después de considerar varias emociones morales como el remordimiento, la compasión y la vergüenza, Arkin decidió centrarse en la modelización de la culpa, ya que puede ser utilizado para condenar un comportamiento específico y generar un cambio constructivo. En el combate, sus robots pueden evaluar los daños y luego usar algoritmos para calcular el nivel adecuado de culpabilidad. Por ejemplo, si el daño incluye las bajas de civiles o de sus bienes, esto aumentaría su nivel de culpabilidad. A medida que el nivel aumenta, los robots podrían elegir las armas con menos riesgo de ocasionar daños colaterales o hasta negarse a luchar.

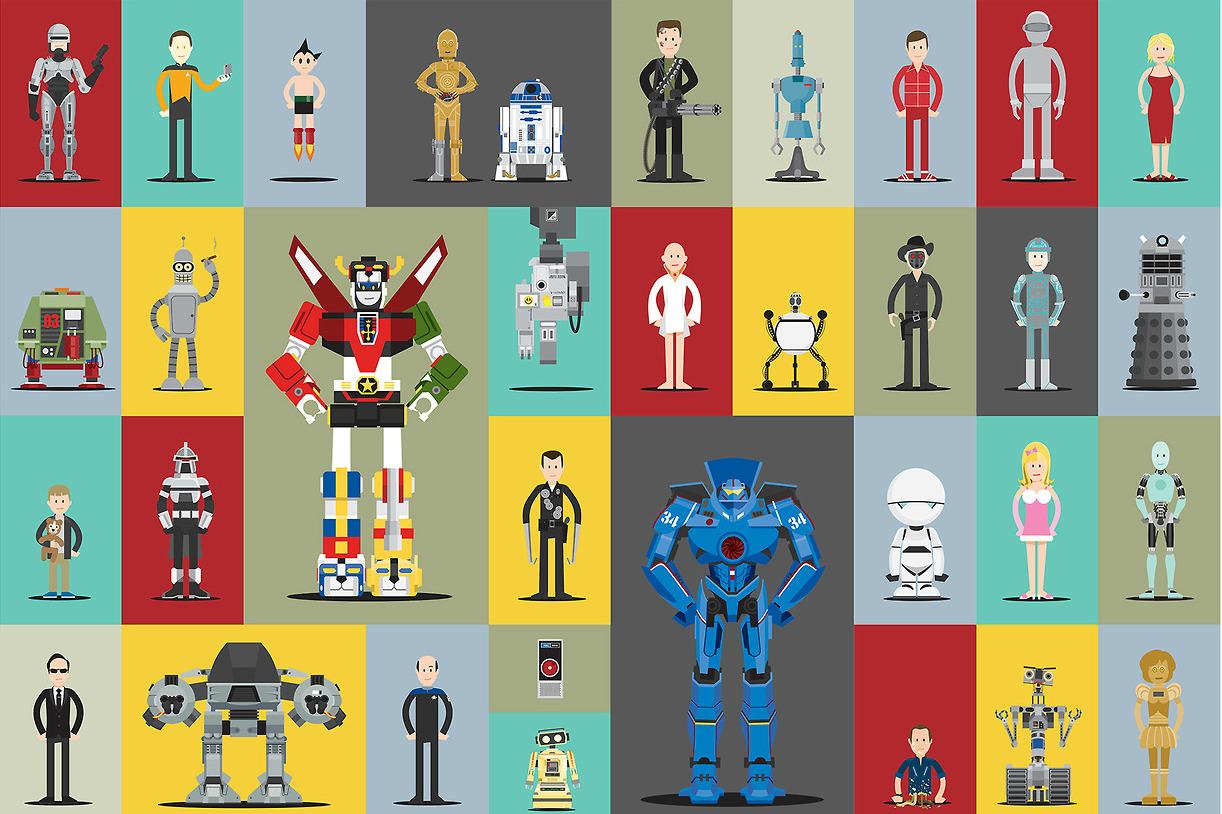

¿Robocops y Terminators a la vista? Los smartcars parecen que lo tienen más difícil.

Fuente: NYT, Ilustración: Scott Park